Economia

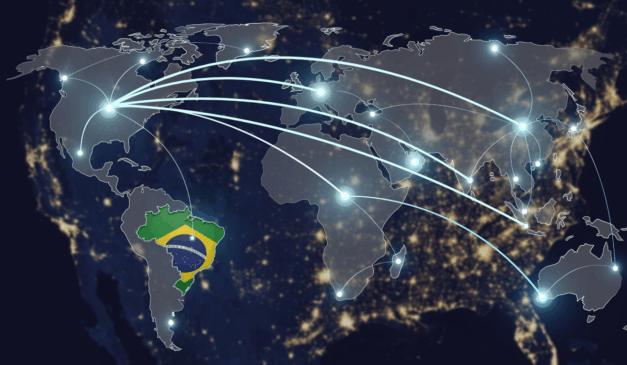

Espírito Santo: a onça que não ruge, mas lidera

Enquanto parte dos estados brasileiros alterna entre promessas populistas e improvisações administrativas, o Espírito Santo trilha uma rota menos barulhenta, porém mais efetiva. Sem ruídos ideológicos ou teatralidades políticas, o estado construiu, nas últimas décadas, um modelo que valoriza previsibilidade, mérito e liberdade econômica. Seu desempenho não decorre de milagres nem de discursos inflamados, mas […]